#CienciaYTecnologia •

Imagina que quieres subir una caja grande y pesada por un tramo de escaleras. Puedes extender los dedos y levantar la caja con ambas manos, luego sostenerla sobre tus antebrazos y equilibrarla contra tu pecho, usando todo tu cuerpo para manipular la caja.

Los humanos generalmente son buenos manipulando todo el cuerpo, pero los robots tienen dificultades con esas tareas. Para el robot, cada punto donde la caja podría tocar cualquier punto de los dedos, brazos y torso del portador representa un evento de contacto sobre el cual debe razonar. Con miles de millones de eventos de contacto potenciales, la planificación de esta tarea rápidamente se vuelve intratable.

Ahora los investigadores del MIT han encontrado una forma de simplificar este proceso, conocida como planificación de manipulación rica en contactos. Utilizan una técnica de IA llamada suavizado, que resume muchos eventos de contacto en un número menor de decisiones, para permitir que incluso un algoritmo simple identifique rápidamente un plan de manipulación efectivo para el robot.

Aunque todavía está en sus inicios, este método podría permitir a las fábricas utilizar robots móviles más pequeños que puedan manipular objetos con todo su brazo o cuerpo, en lugar de grandes brazos robóticos que sólo pueden agarrar con las yemas de los dedos. Esto puede ayudar a reducir el consumo de energía y reducir los costos. Además, esta técnica podría ser útil en robots enviados en misiones de exploración a Marte u otros cuerpos del sistema solar, ya que podrían adaptarse rápidamente al entorno utilizando únicamente un ordenador a bordo.

“En lugar de pensar en esto como un sistema de caja negra, si podemos aprovechar la estructura de este tipo de sistemas robóticos utilizando modelos, existe la oportunidad de acelerar todo el procedimiento para intentar tomar estas decisiones y llegar a soluciones ricas en contactos”. planes”, dice HJ Terry Suh, estudiante de posgrado en ingeniería eléctrica e informática (EECS) y coautor principal de un artículo sobre esta técnica.

Junto a Suh en el artículo se encuentra el coautor principal Tao Pang Ph.D. ’23, robótico del Boston Dynamics AI Institute; Lujie Yang, estudiante de posgrado de EECS; y el autor principal Russ Tedrake, profesor Toyota de EECS, Aeronáutica y Astronáutica e Ingeniería Mecánica, y miembro del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL). La investigación aparece esta semana en IEEE Transactions on Robotics.

Aprendiendo sobre el aprendizaje

El aprendizaje por refuerzo es una técnica de aprendizaje automático en la que un agente, como un robot, aprende a completar una tarea mediante prueba y error con una recompensa por acercarse a una meta. Los investigadores dicen que este tipo de aprendizaje requiere un enfoque de caja negra porque el sistema debe aprender todo sobre el mundo mediante prueba y error.

Se ha utilizado eficazmente para la planificación de manipulación rica en contactos, donde el robot busca aprender la mejor manera de mover un objeto de una manera específica.

Pero como puede haber miles de millones de puntos de contacto potenciales sobre los que un robot debe razonar al determinar cómo usar sus dedos, manos, brazos y cuerpo para interactuar con un objeto, este enfoque de prueba y error requiere una gran cantidad de cálculos.

“El aprendizaje por refuerzo puede necesitar pasar millones de años en tiempo de simulación para poder realmente aprender una política”, añade Suh.

Por otro lado, si los investigadores diseñan específicamente un modelo basado en la física utilizando su conocimiento del sistema y la tarea que quieren que realice el robot, ese modelo incorpora una estructura sobre este mundo que lo hace más eficiente.

Sin embargo, los enfoques basados en la física no son tan efectivos como el aprendizaje por refuerzo cuando se trata de planificación de manipulación rica en contactos; Suh y Pang se preguntaron por qué.

Realizaron un análisis detallado y descubrieron que una técnica conocida como suavizado permite que el aprendizaje por refuerzo funcione tan bien.

Muchas de las decisiones que un robot podría tomar al determinar cómo manipular un objeto no son importantes en el gran esquema de las cosas. Por ejemplo, cada ajuste infinitesimal de un dedo, ya sea que entre en contacto o no con el objeto, no importa mucho. Los promedios suavizados eliminan muchas de esas decisiones intermedias y sin importancia, dejando algunas importantes.

El aprendizaje por refuerzo realiza el suavizado implícitamente probando muchos puntos de contacto y luego calculando un promedio ponderado de los resultados. Basándose en esta información, los investigadores del MIT diseñaron un modelo simple que realiza un tipo similar de suavizado, lo que le permite centrarse en las interacciones centrales entre robot y objeto y predecir el comportamiento a largo plazo. Demostraron que este enfoque podría ser tan eficaz como el aprendizaje por refuerzo para generar planes complejos.

“Si sabes un poco más sobre tu problema, puedes diseñar algoritmos más eficientes”, afirma Pang.

Una combinación ganadora

Aunque suavizar simplifica enormemente las decisiones, buscar entre las decisiones restantes todavía puede ser un problema difícil. Entonces, los investigadores combinaron su modelo con un algoritmo que puede buscar rápida y eficientemente todas las decisiones posibles que el robot podría tomar.

Con esta combinación, el tiempo de cálculo se redujo a aproximadamente un minuto en una computadora portátil estándar.

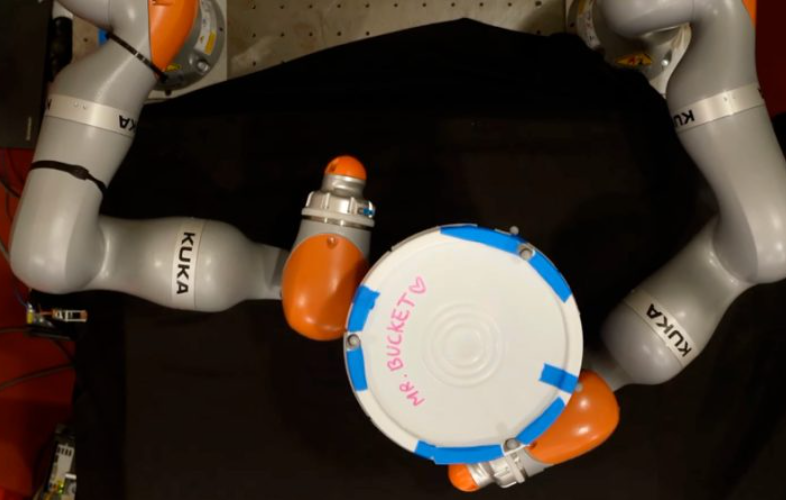

Primero probaron su enfoque en simulaciones en las que a manos robóticas se les asignaban tareas como mover un bolígrafo a una configuración deseada, abrir una puerta o recoger un plato. En cada caso, su enfoque basado en modelos logró el mismo rendimiento que el aprendizaje por refuerzo, pero en una fracción del tiempo. Vieron resultados similares cuando probaron su modelo en hardware en brazos robóticos reales.

“Las mismas ideas que permiten la manipulación de todo el cuerpo también funcionan para la planificación con manos diestras, parecidas a las humanas. Anteriormente, la mayoría de los investigadores decían que el aprendizaje por refuerzo era el único enfoque que escalaba a manos diestras, pero Terry y Tao demostraron que al tomar esta clave idea de suavización (aleatorizada) a partir del aprendizaje por refuerzo, también pueden hacer que los métodos de planificación más tradicionales funcionen muy bien”, afirma Tedrake.

Sin embargo, el modelo que desarrollaron se basa en una aproximación más simple del mundo real, por lo que no puede manejar movimientos muy dinámicos, como la caída de objetos. Si bien es eficaz para tareas de manipulación más lentas, su enfoque no puede crear un plan que permita a un robot tirar una lata a un contenedor de basura, por ejemplo. En el futuro, los investigadores planean mejorar su técnica para poder abordar estos movimientos altamente dinámicos.

“Si estudias tus modelos cuidadosamente y realmente entiendes el problema que estás tratando de resolver, definitivamente hay algunos beneficios que puedes lograr. Hay beneficios al hacer cosas que van más allá de la caja negra”, dice Suh.

techxplore.com